WIDER THAN THE SKY – Più grande del cielo

L’intelligenza artificiale tra scienza, arte e mistero umano

Presentato alla prossima Festa del Cinema di Roma – RoFF 2025, nella sezione Special Screening

IN SALA PROSSIMAMENTE CON WANTED CINEMA

Una produzione Aura Film, in coproduzione con RSI Radiotelevisione Svizzera, Ameuropa International, con RAI Cinema

Che cos’è davvero l’intelligenza artificiale? Una straordinaria opportunità, un rischio globale, o forse una grande illusione? Wider Than The Sky – Più grande del cielo è il nuovo film documentario di Valerio Jalongo, presentato in anteprima nazionale alla Festa del Cinema di Roma 2025 nella sezione Special Screening, che cerca una risposta a queste domande con gli strumenti della scienza, della poesia e dell’arte.

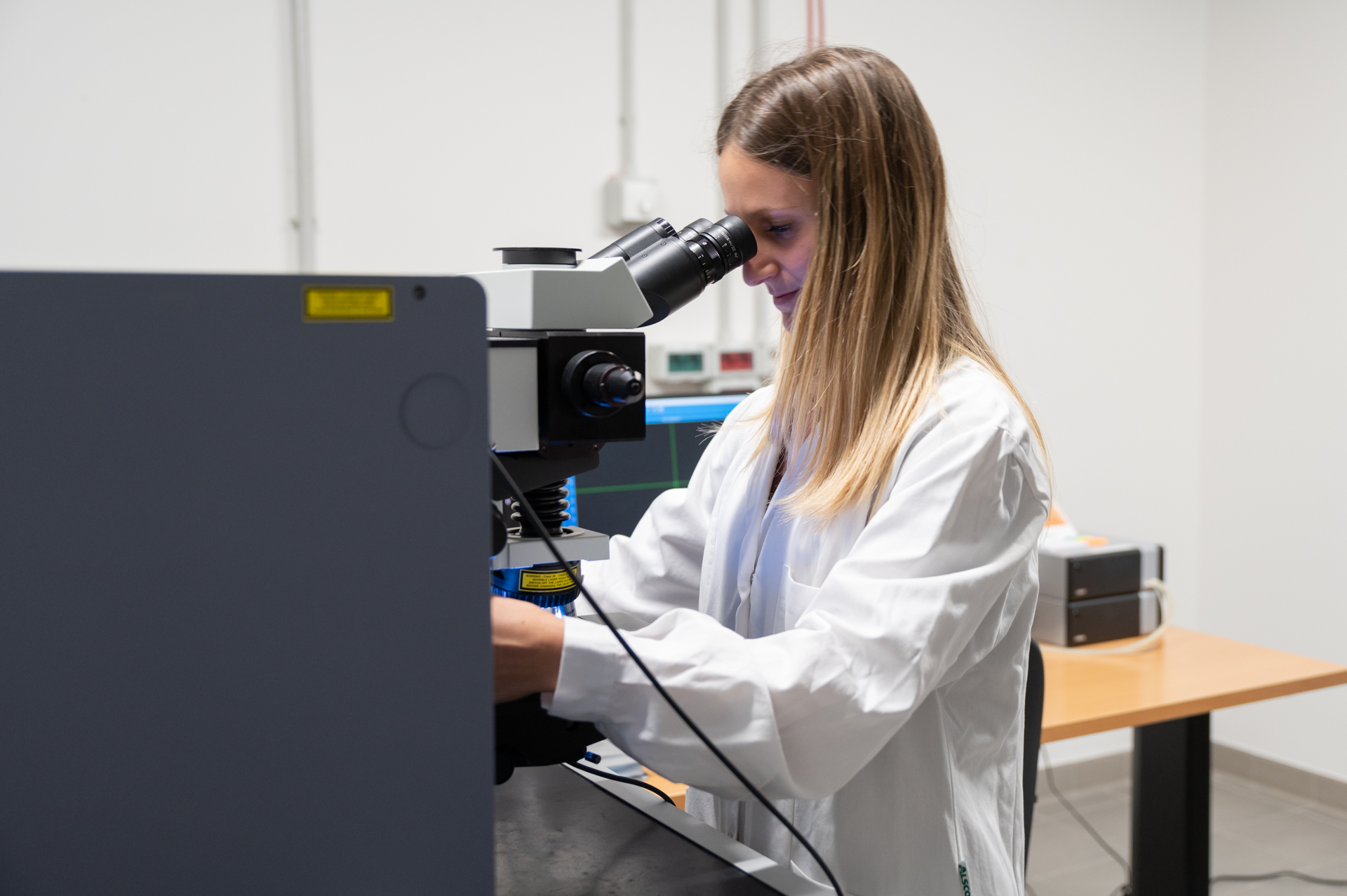

Girato in oltre dieci città tra Europa, Stati Uniti e Giappone, il film mette in dialogo neuroscienziati, filosofi, artisti e robot umanoidi per interrogarsi sul futuro dell’umanità di fronte a una tecnologia che sta ridefinendo le nostre vite.

Wider Than The Sky – Più grande del cielo è una produzione internazionale, un’indagine senza confini politici e geografici realizzato in collaborazione con la comunità scientifica europea dell’Human Brain Project e la compagnia di danza Sasha Waltz & Guests. Protagonisti del film sono pensatori e innovatori di fama mondiale, tra cui Antonio Damasio, Andrea Moro, Rob Reich, Refik Anadol, Hany Farid, Rainer Goebel, Sasha Waltz, Sougwen Chung, e i robot Anymal e Ameca che mostrano i punti di contatto tra ricerca neuroscientifica, arti performative e robotica avanzata.

“Non dovremmo chiamarla intelligenza artificiale – afferma Jalongo – ma intelligenza collettiva, perché nulla esisterebbe senza la conoscenza condivisa dell’umanità. La vera sfida è decidere se questa rivoluzione sarà usata per concentrare il potere o per costruire un futuro aperto e democratico” dichiara Jalongo che, dopo Il senso della bellezza e L’acqua l’insegna la sete, torna al cinema quale mezzo di riflessione necessaria sul nostro presente, tra emozione e profonda inquietudine.

Con immagini sorprendenti e momenti di grande intensità visiva – dalle coreografie di Sasha Waltz ai droni da competizione, fino ai laboratori di robotica di Zurigo – Wider Than The Sky – Più grande del cielo svela un’IA non solo come sfida tecnologica, ma come mistero profondamente umano, destinato a cambiare radicalmente il nostro rapporto con la conoscenza, la creatività e la libertà.

Wider Than The Sky – Più grande del cielo è una produzione Aura Film, RSI Radiotelevisione Svizzera, Ameuropa International, con RAI Cinema e sarà disponibile da subito per le programmazioni nei cinema con matineé dedicate e rivolte alle scuole, e nelle sale italiane prossimamente con Wanted.

NOTE DI REGIA

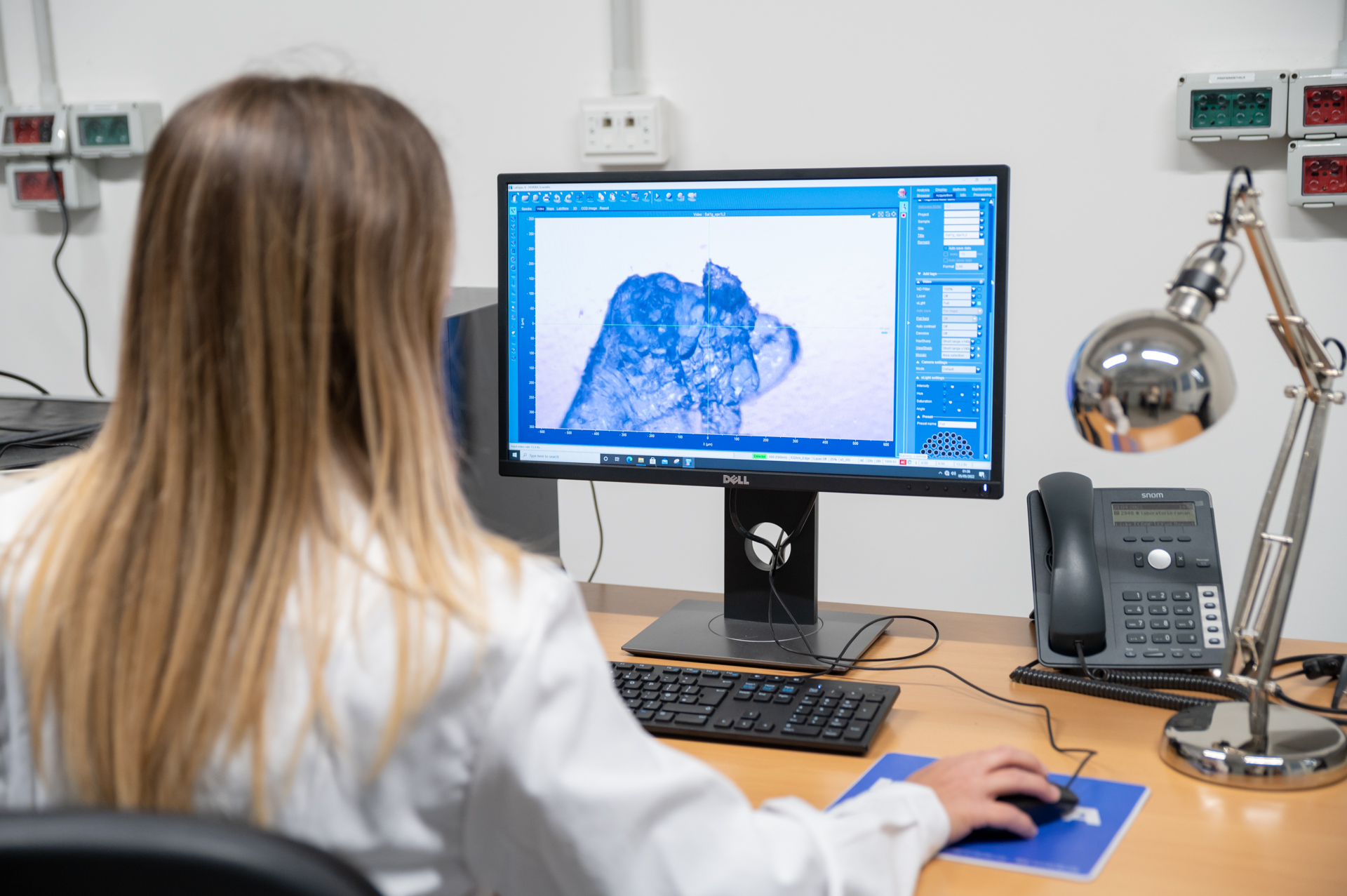

Abbiamo mappe della Terra dettagliate fino al centimetro. Mappe dell’universo risalenti a un miliardesimo di secondo dopo il Big Bang. Abbiamo mappe precise di tutto… tranne che dei nostri cervelli.

Ora, per la prima volta, ci stiamo avvicinando alla creazione di una mappa 3D di quello che viene definito l’oggetto più complesso dell’universo: il cervello umano. Per anni, un’ampia comunità internazionale di neuroscienziati, l’Human Brain Project, ha collaborato a questo compito gigantesco.

Ma tracciare territori sconosciuti è rischioso: le mappe possono servire anche a scatenare guerre di conquista, ad affermare proprietà e sfruttamenti. Lo sviluppo dell’IA deve molto a ciò che stiamo scoprendo sul cervello umano. E se invece trovassimo che questa tecnologia perfeziona strumenti di controllo politico e sociale, dando a pochi privilegiati una sorta di “sguardo divino” su tutto? E se aiutasse a concentrare la ricchezza nelle mani di pochi? E se rendesse la guerra ancora più letale?

L’intelligenza artificiale è già utilizzata per creare un divario di potere senza precedenti nella storia. Il suo uso indiscriminato potrebbe generare un mondo disumanizzato di topi e uomini, dove chi si oppone al potere dominante è costretto a vivere sottoterra, privato di tutto per sfuggire al controllo.

Non si tratta di una profezia fantascientifica lontana: è la cronaca recente.

A Gaza, i sistemi di IA sono stati utilizzati per incrociare miliardi di dati, localizzare combattenti di Hamas e stimare il numero di civili “ammessi” come perdite collaterali, senza necessità di valutazioni umane caso per caso.

H.G. Wells scrisse che la nostra civiltà è impegnata in una corsa tra conoscenza e catastrofe. Una società a scatola nera, dove algoritmi oscuri governano le nostre vite, potrebbe far pendere l’ago della bilancia verso il disastro.

“Wider Than the Sky” mi ha reso consapevole della vera natura dell’intelligenza artificiale: presentarla solo come miracolo tecnologico fa parte della menzogna che ne legittima la privatizzazione.

La verità sta invece dove nessuno guarda, in una dimensione opposta: l’IA sarebbe nulla senza tutta la conoscenza che l’umanità ha creato nella sua storia. Per questo, essa appartiene all’intera umanità, per la sua origine profondamente spirituale.

Dovremmo smettere di definirla “artificiale” e forse chiamarla “intelligenza collettiva”.

Abbiamo già un grande modello da seguire: gli scienziati e gli artisti che collaborano in squadre internazionali, scambiando esperienze e conoscenze liberamente, senza altra affiliazione che quella della razza umana, senza altro scopo che il bene dell’umanità.

Questa è la base di una IA “affidabile” e probabilmente anche il miglior antidoto contro i rischi di una società a scatola nera.

UNA PRODUZIONE AURA FILM

IN COPRODUZIONE CON RSI RADIOTELEVISIONE SVIZZERA

E AMEUROPA INTERNATIONAL CON RAI CINEMA

CON SASHA WALTZ, ANTONIO DAMASIO, REFIK ANADOL, KATRIN AMUNTS, ADAM RUSSELL, RAINER GOEBEL, ROB REICH, DAVID YOUNG, HANNA DAMASIO, JONAS T. KAPLAN, KINGSON MAN, HANY FARID, ANDREA MORO, MARVIN SCHÄPPER, THOMAS BITMATTA, ALEX VANOVER, NIKITA RUDIN, WILL JACKSON, e AMECA

REGIA E SCENEGGIATURA VALERIO JALONGO MONTAGGIO

MICHELANGELO GARRONE

DIRETTORE DELLA FOTOGRAFIA IAN OGGENFUSS

INGEGNERE DEL SUONO BALTHASAR JUCKER

SOUND DESIGNER LILIO ROSATO

MUSICHE DANIELA PES, KETY FUSCO

AIUTO REGIA ATTILIO DI TURI

GRADING ROGER SOMMER

FONICO DI MIX SANDRO ROSSI

GRAFICHE E TITOLI ELISA MACCELLI

MONTAGGIO DIALOGHI OMAR ABOUZAID

DELEGATI DI PRODUZIONE PER RSI RADIOTELEVISIONE SVIZZERA/ SSR SRG SILVANA BEZZOLA RIGOLINI, GIULIA FAZIOLI, ALESSANDRO MARCIONNI

LINE PRODUCER TINA BOILLAT, MARTINA LATINI

PRODOTTO DA PASCAL TRÄCHSLIN, VALERIO JALONGO

CON IL SUPPORTO DI UFFICIO FEDERALE DELLA CULTURA, REPUBBLICA E CANTONE TICINO, FILMPLUS DELLA SVIZZERA ITALIANA, SUISSIMAGE, MEDIA DESK SUISSE, ERNST GÖHNER STIFTUNG, TICINO FILM COMMISSION, MINISTERO DELLA CULTURA – DIREZIONE GENERALE CINEMA E AUDIOVISIVO, REGIONE LAZIO

Testo e immagini dall’Ufficio Stampa Echo Group, Wanted Cinema.