IL CICLO MESTRUALE E LA LUNA: UNA SINCRONIZZAZIONE SEMPRE PIÙ RARA

L’Università di Padova partecipa allo studio internazionale che rivela la perdita della sincronia con la Luna a causa dell’inquinamento luminoso

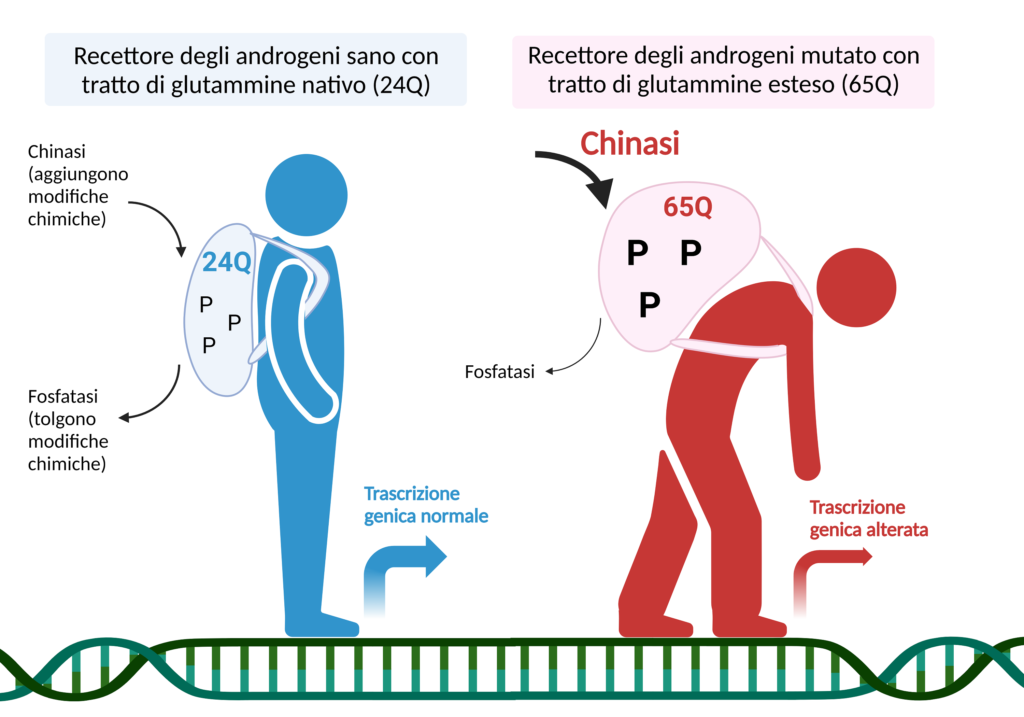

Molte specie animali sincronizzano il loro comportamento riproduttivo con una determinata fase del ciclo lunare per aumentare il successo nella procreazione. Negli esseri umani, l’influenza della luna sul comportamento riproduttivo rimane controversa, sebbene il ciclo mestruale abbia un periodo molto prossimo a quello dei cicli lunari.

È già stato dimostrato come i cicli mestruali femminili si sincronizzino in maniera intermittente con i cicli di luminanza (che descrivono la quantità di luce lunare visibile nel corso del mese, che varia dalla luminanza minima del Novilunio alla luminanza massima del Plenilunio) e/o gravitazionali della luna (l’influenza gravitazionale della Luna sulla Terra che provoca le maree).

Con l’avanzare dell’età e l’esposizione alla luce artificiale notturna, i cicli mestruali tendono ad accorciarsi e la sincronia con la luna si perde. Nello studio appena pubblicato sulla rivista «Science Advances» e che vede tra gli autori Sara Montagnese e Alberto Ferlin, del Dipartimento di Medicina dell’Università di Padova e Rodolfo Costa del Dipartimento di Scienze Biomediche dell’Università di Padova, i ricercatori hanno dimostrato come i cicli mestruali di 176 donne che ne avessero registrato l’inizio per almeno due anni fossero sincronizzati con il ciclo lunare in modo molto evidente fino al 2010, anno dell’introduzione massiva di illuminazione a LED in Europa, che si è aggiunta all’utilizzo diffuso di smartphone.

Con l’aumento cospicuo dell’inquinamento luminoso, dal 2010 in poi, tale sincronizzazione si osserva prevalentemente nel mese di gennaio, quando le forze gravitazionali esercitate dal sistema Sole-Terra-Luna sono più forti. Di questo i ricercatori hanno trovato conferma anche analizzando l’andamento temporale di ricerche internet pertinenti (ad esempio “dolore mestruale”) con Google Trends, uno strumento che consente di valutare l’interesse nel tempo e in diverse regioni per specifici argomenti.

«Sembra quindi probabile che la crescente esposizione notturna alla luce artificiale interferisca con la sincronizzazione con i cicli lunari di luminanza – spiega Sara Montagnese –. Complessivamente, la sincronizzazione tra il ciclo mestruale femminile e i cicli lunari è quindi ridotta rispetto al passato e rimane rilevabile prevalentemente nei periodi in cui le forze gravitazionali nel sistema Sole-Terra-Luna sono più intense».

La luce artificiale non solo “oscura” la luce naturale della luna, ma tende anche ad accorciare la durata del ciclo mestruale, collegata all’età e alla fertilità femminile: i risultati appena pubblicati potrebbero avere implicazioni importanti non solo per la fisiologia e il comportamento, ma anche per la fertilità e soprattutto la nota riduzione della stessa nel mondo occidentale.

Riferimenti bibliografici:

Charlotte Helfrich-Förster et al., Synchronization of women’s menstruation with the Moon has decreased but remains detectable when gravitational pull is strong, Sci. Adv. 11, eadw4096 (2025), DOI: 10.1126/sciadv.adw4096

Testo e immagini dall’Ufficio Stampa dell’Università di Padova