CUORE METTE NUOVI LIMITI ALL’INSOLITO COMPORTAMENTO DEI NEUTRINI

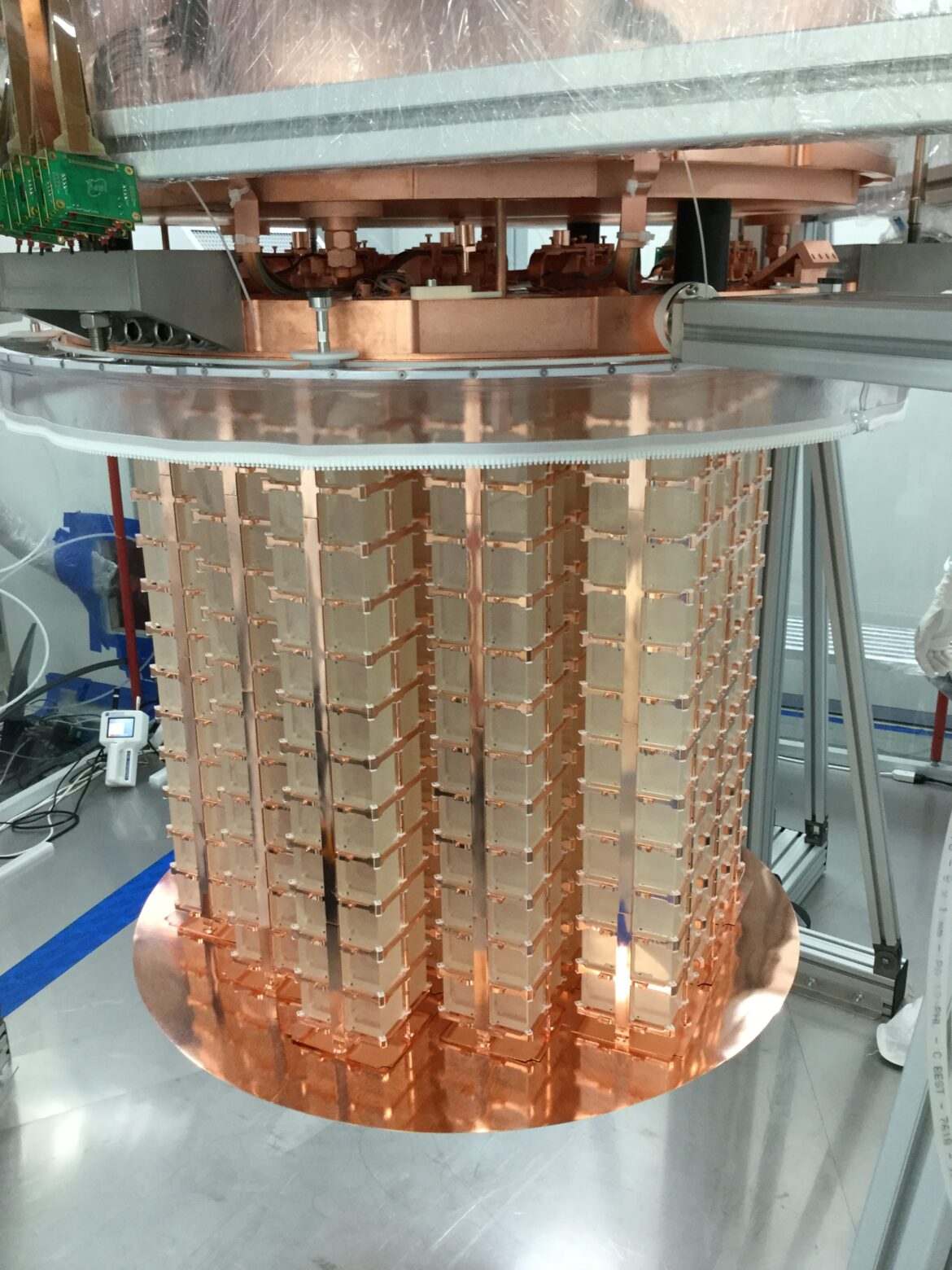

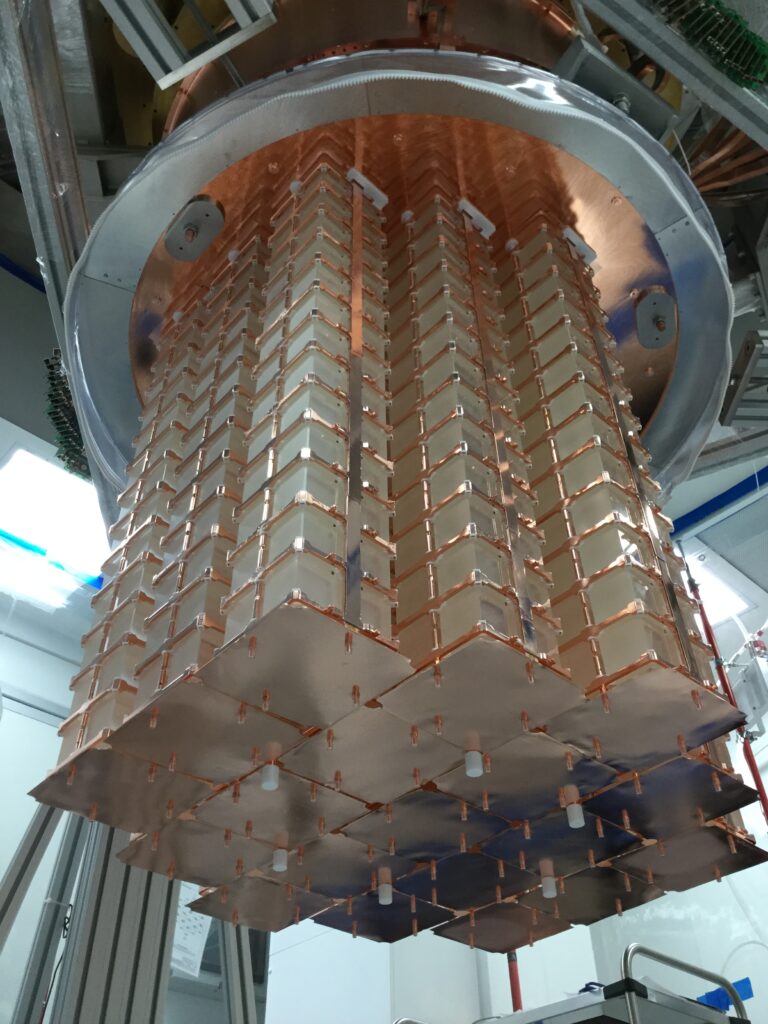

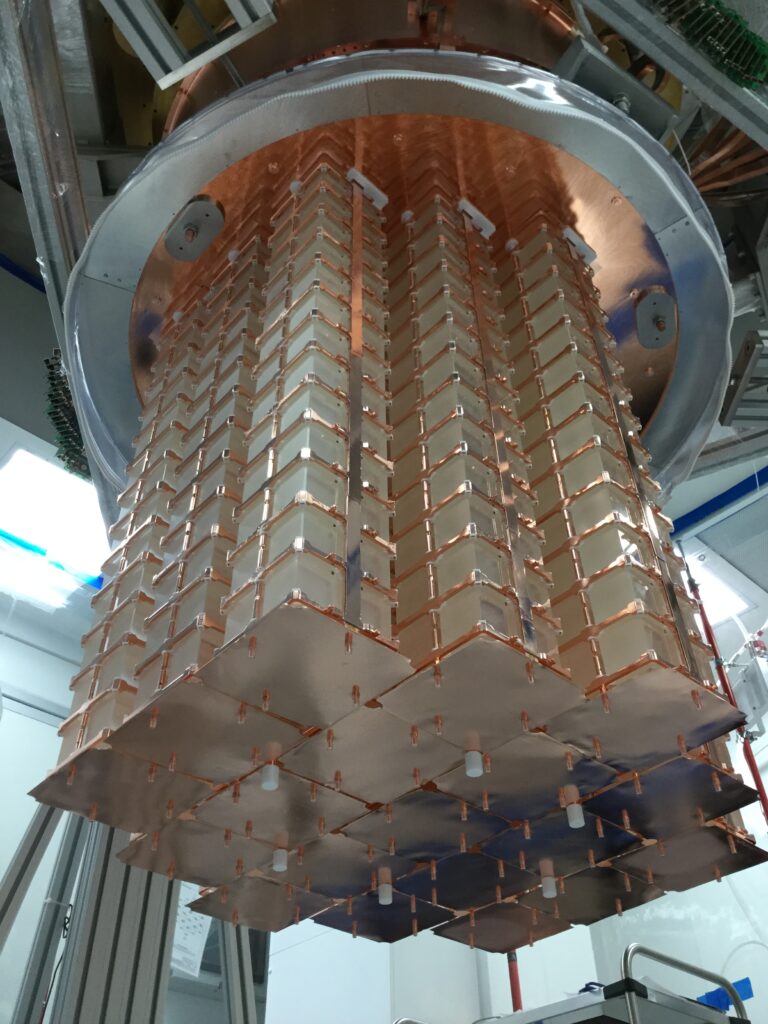

Le ricercatrici e i ricercatori dell’esperimento CUORE (Cryogenic Underground Observatory for Rare Events) situato ai Laboratori Nazionali del Gran Sasso dell’Istituto Nazionale di Fisica Nucleare (INFN) hanno pubblicato oggi, 6 aprile, su Nature i nuovi risultati sulla natura del neutrino, che dimostrano inoltre l’eccezionalità della tecnologia sviluppata, in grado di mantenere un rivelatore di oltre 700 kg a temperature vicine allo zero assoluto, per più di tre anni.

CUORE, che opera nel silenzio cosmico delle sale sperimentali sotterranee dei Laboratori del Gran Sasso, protetto da 1.400 metri di roccia, è tra gli esperimenti più sensibili al mondo per lo studio di un processo nucleare, chiamato doppio decadimento beta senza emissione di neutrini, possibile solo se neutrino e antineutrino sono la stessa particella. Questo decadimento, se osservato, chiarirebbe per la prima volta il mistero della natura di Majorana del neutrino. I risultati di CUORE si basano su una quantità di dati, raccolta negli ultimi tre anni, dieci volte più grande di qualsiasi altra ricerca con tecnica sperimentale simile. Nonostante la sua fenomenale sensibilità, l’esperimento non ha ancora osservato prove di eventi di questo tipo. Da questo risultato è possibile stabilire che un atomo di tellurio impiega più di 22 milioni di miliardi di miliardi di anni per decadere. I nuovi limiti di CUORE sul comportamento dei neutrini sono cruciali nella ricerca di una possibile nuova scoperta della fisica delle particelle, che sarebbe rivoluzionaria perché aiuterebbe a comprendere le nostre stesse origini.

“L’obiettivo è capire come ha avuto origine la materia”, spiega Carlo Bucci, ricercatore dei Laboratori Nazionali del Gran Sasso e responsabile internazionale dell’esperimento CUORE.

“Stiamo cercando un processo che violi una simmetria fondamentale della natura”, aggiunge Roger Huang, giovane ricercatore del Lawrence Berkeley National Laboratory del Department of Energy degli Stati Uniti e uno degli autori del nuovo studio. “L’asimmetria tra materia e antimateria nell’universo è ancora un rebus”, dice Huang. “Se i neutrini sono le loro stesse antiparticelle, questo potrebbe aiutare a risolverlo”.

“Il doppio decadimento beta senza emissione di neutrini, se sarà misurato, sarà il processo più raro mai osservato in natura, con un tempo di decadimento di oltre un milione di miliardi di volte superiore all’età dell’universo”, afferma Danielle Speller, professoressa alla Johns Hopkins University e componente del Physics Board di CUORE.

CUORE è un vero trionfo scientifico e tecnologico, non solo per i suoi nuovi risultati, ma anche per aver dimostrato con successo il funzionamento del suo criostato in condizioni veramente estreme, alla temperatura di 10 millesimi di grado sopra lo zero assoluto (10 milliKelvin). La temperatura nel rivelatore CUORE viene attentamente monitorata con sensori in grado di rilevare una variazione di appena un decimillesimo di grado Celsius. Il doppio decadimento beta senza emissione di neutrini ha una firma energetica specifica e aumenterebbe la temperatura di un singolo cristallo di una quantità ben definita e riconoscibile.

“È il più grande refrigeratore del suo genere al mondo”, sottolinea Paolo Gorla, ricercatore dei Laboratori del Gran Sasso e Technical Coordinator di CUORE. “Capace di mantenere la temperatura di 10 milliKelvin ininterrottamente per circa tre anni”. Una tale tecnologia ha applicazioni ben oltre la fisica delle particelle fondamentali. In particolare, può trovare impiego nella realizzazione dei computer quantistici, dove una delle principali difficoltà dal punto di vista tecnologico è mantenerli sufficientemente freddi e schermati dalle radiazioni ambientali.

“Lo straordinario funzionamento del criostato di CUORE è il coronamento di una lunga sfida tecnologica iniziata a metà degli anni ‘80 dal gruppo di Ettore Fiorini a Milano, che ha visto l’evoluzione dei rivelatori criogenici, da cristalli di pochi grammi agli oltre 700 kg degli attuali”, aggiunge Oliviero Cremonesi, Presidente della Commissione Scientifica Nazionale per la fisica astroparticellare dell’INFN.

“La sensibilità del rivelatore è davvero fenomenale,” afferma Laura Marini, ricercatrice presso il Gran Sasso Science Institute e Run Coordinator di CUORE, “al punto che osserviamo segnali generati da vibrazioni microscopiche della crosta terrestre.” “Abbiamo visto effetti dovuti a terremoti in Cile e Nuova Zelanda”, continua Marini “misuriamo costantemente il segnale delle onde che si infrangono sulla riva del mare Adriatico, a 60 chilometri di distanza, che diventa più forte in inverno, quando c’è tempesta”.

CUORE sta facendo da apripista per la prossima generazione di esperimenti: il suo successore, CUPID (CUORE Upgrade with Particle Identification), è già in avanzata fase di sviluppo e sarà oltre dieci volte più sensibile di CUORE. Nel frattempo, CUORE non ha ancora finito.

“Saremo operativi fino al 2024 – aggiunge Bucci – e sono impaziente di vedere che cosa troveremo”.

CUORE è gestito da una collaborazione di ricerca internazionale, guidata dall’INFN in Italia e dal Berkeley National Laboratory negli Stati Uniti.

APPROFONDIMENTI

Particelle particolari

I neutrini sono ovunque: ci sono quasi mille miliardi di neutrini che passano attraverso l’unghia di un tuo dito mentre leggi questa frase. Non sentono l’effetto delle due forze più intense dell’universo, l’elettromagnetismo e la forza nucleare forte, e questo consente loro di passare attraverso la materia, quindi anche attraverso tutta la Terra, senza interagire. Nonostante il numero enorme, la loro natura così elusiva li rende molto difficili da studiare, sono un vero grattacapo per i fisici. L’esistenza di queste particelle è stata postulata per la prima volta oltre 90 anni fa, ma fino alla fine degli anni ’90 non si sapeva nemmeno se i neutrini avessero una massa, ora sappiamo di sì ma è davvero molto piccola.

Una delle tante domande ancore aperte sui neutrini è se siano le loro stesse antiparticelle. Tutte le altre particelle hanno delle corrispondenti antiparticelle, la loro controparte di antimateria: agli elettroni corrispondono gli antielettroni (positroni), ai quark gli antiquark, ai neutroni e ai protoni (che sono i costituenti dei nuclei atomici) gli antineutroni e gli antiprotoni. A differenza di tutte le altre particelle, è possibile che i neutrini siano le loro stesse antiparticelle. Un tale scenario è stato teorizzato per la prima volta dal fisico Ettore Majorana nel 1937 e le particelle che mostrano questa proprietà sono conosciute come fermioni di Majorana.

Se i neutrini fossero davvero fermioni di Majorana potremmo forse rispondere a una domanda che è alla base della nostra stessa esistenza: perché c’è così tanta più materia che antimateria nell’universo?

Un dispositivo raro per decadimenti rari

Determinare se i neutrini siano le loro stesse antiparticelle è difficile, proprio perché essi non interagiscono molto spesso. Il miglior strumento dei fisici per cercare i neutrini di Majorana è un ipotetico tipo di decadimento naturale radioattivo chiamato decadimento doppio beta senza neutrini. Il decadimento beta è una forma abbastanza comune di decadimento in alcuni atomi, che trasforma un neutrone di un nucleo atomico in un protone, mutando l’elemento chimico dell’atomo ed emettendo un elettrone e un antineutrino come conseguenza del processo. Il doppio decadimento beta è più raro: invece di un solo neutrone, due di essi si trasformano in due protoni allo stesso tempo, emettendo due elettroni e due antineutrini. Ma se il neutrino è un fermione di Majorana, allora teoricamente un singolo neutrino “virtuale”, che funge da antiparticella di sé stesso, potrebbe prendere il posto di entrambi gli antineutrini e solo i due elettroni sarebbero emessi dal nucleo atomico, da qui il nome del processo. Il decadimento doppio beta senza neutrini è stato teorizzato per decenni, ma non è mai stato osservato.

L’esperimento CUORE è impegnato a rivelare negli atomi di tellurio un decadimento doppio beta senza neutrini. L’esperimento utilizza quasi mille cristalli di ossido di tellurio purissimo, del peso complessivo di oltre 700 kg. Questa grande quantità di tellurio è necessaria perché, in media, ci vuole più di un miliardo di volte l’età dell’Universo perché un singolo atomo instabile di tellurio subisca un normale doppio decadimento beta. Ma ci sono milioni di miliardi di miliardi di atomi di tellurio in ciascuno dei cristalli utilizzati da CUORE, il che significa che il doppio decadimento beta standard (con emissione di due neutrini) avviene abbastanza regolarmente nel rivelatore, circa alcune volte al giorno in ciascun cristallo. Il doppio decadimento beta senza neutrini, ammesso che si verifichi, è estremamente più raro, e quindi la Collaborazione di CUORE deve impegnarsi per rimuovere quante più fonti di interferenza possibile che potrebbero nascondere l’evento cercato. Per schermare il rivelatore dai raggi cosmici, l’intero sistema si trova nelle sale sperimentali sotterranee dei Laboratori del Gran Sasso, dove i 1400 metri di roccia sovrastanti proteggono gli esperimenti dai raggi cosmici che piovono incessantemente sulla Terra. Una ulteriore schermatura è fornita da diverse tonnellate di piombo. Il piombo appena prodotto è leggermente radioattivo a causa della contaminazione naturale da uranio e altri elementi. Questo livello di radioattività è assolutamente trascurabile per qualsiasi tipo di utilizzo del piombo, eccetto per un rivelatore così sensibile come CUORE. Poiché la radioattività diminuisce nel tempo, il piombo utilizzato per circondare i rivelatori di CUORE è principalmente piombo recuperato da un’antica nave romana affondata quasi 2000 anni fa al largo delle coste della Sardegna.

CUORE è finanziato negli Stati Uniti dal Department of Energy (DoE) e dalla National Science Foundation (NSF) e in Italia dall’INFN, l’Istituto Nazionale di Fisica Nucleare. La Collaborazione CUORE include in Italia i Laboratori Nazionali del Gran Sasso, i Laboratori Nazionali di Frascati e i Laboratori Nazionali di Legnaro dell’INFN e le Sezioni INFN e Università di Bologna, Università di Genova, Università di Milano Bicocca, Sapienza Università di Roma e il Gran Sasso Science Institute; negli Stati Uniti: California Polytechnic State University, San Luis Obispo; Lawrence Berkeley National Laboratory; Johns Hopkins University; Lawrence Livermore National Laboratory; Massachusetts Institute of Technology; University of California, Berkeley; University of California, Los Angeles; University of South Carolina; Virginia Polytechnic Institute and State University; Yale University; in Francia: Saclay Nuclear Research Center (CEA) e Irène Joliot-Curie Laboratory (CNRS/IN2P3, Paris Saclay University); in Cina: Fudan University e Shanghai Jiao Tong University.

Testo e immagini dall’Ufficio Stampa INFN Istituto Nazionale di Fisica Nucleare